25 03 2014

Partie 6: Configuration du teaming sous SCVMM 2012 SP1/R2 (7/7)

Etape 9-10-11: Ajout du Logical Switch sur le serveur Hyper-V

Introduction et Création des Logical Networks (1/7)

Création des Network Sites (2/7)

Création des IP Adress Pools (3/7)

Création des VM Networks (4/7)

Création de l’Uplink Port Profile (>>> c’est là que nous configurons une partie du teaming <<<) (5/7)

Création du Logical Switch (>>> Encore un peu de teaming par ici <<<) (6/7)

Ajout du Logical Switch sur le serveur Hyper-V et Conclusion (7/7)

Etape 9-10-11: Ajout du Logical Switch sur le serveur Hyper-V

Voilà enfin les dernières étapes qui sont les plus intéressantes ! Nous allons ajouter le Logical Switch sur notre serveur Hyper-V. En ajoutant celui-ci, nous ajoutons automatiquement tous les Logical Networks (et VM Networks) à notre serveur Hyper-V.

L’étape suivante (à faire en même temps), va consister à ajouter les Virtual Network Adapters dédiés à la partition de management, pour utiliser les réseaux de Management, Cluster, LiveMigration et iSCSI !

Par simplification, je vous propose cette fois-ci encore de réaliser les étapes 9, 10 et 11 en une seule étape !

Avec la console SCVMM:

- Rendez-vous dans l’onglet Fabric de votre console SCVMM 2012 SP1 ou R2.

- Sélectionnez le serveur Hyper-V à configurer puis dans le bandeau, cliquez sur le bouton Properties.

- Sélectionnez l’onglet Virtual Switches.

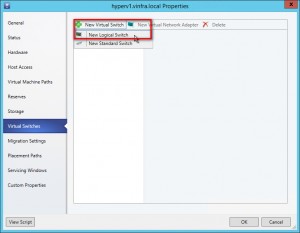

- Cliquez sur l’onglet New Virtual Switch puis New Logical Switch.

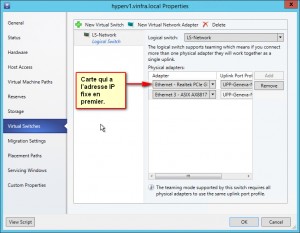

- Une fois créé, vous allez pouvoir sélectionné le Logical Switch que nous venons de créer.

- Sélectionnez la première carte à ajouter. Si il s’agit de la carte qui détient actuellement l’adresse IP du serveur Hyper-V, ce doit être LA PREMIERE. De cette manière, lors de la configuration de la carte de management, elle prendra l’adresse IP existante, ce qui évite de perdre le serveur Hyper-V et de terminer la configuration en erreur.

- Ajoutez les autres cartes à ajouter au teaming réseau.

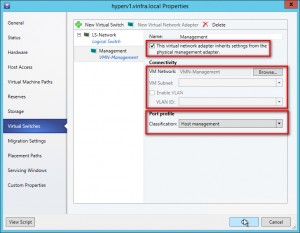

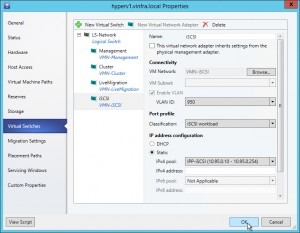

- Puis cliquez sur New Virtual Network Adapter.

- Donnez lui un nom, par exemple Management, puis sélectionnez This virtual network adapter inherits settings from the physical management adapter pour récupérer l’adresse IP existante.

- Ensuite connectez là au VM Network Host Management.

- Si vous utilisez les vLan, cliquez sur Enable VLAN et sélectionnez le vLan du Network Site.

- Enfin, sélectionnez la classification correspondante, ici Host Management.

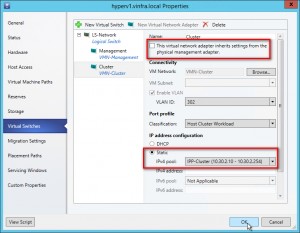

- Recommencez pour chaque virtual network adapter (LiveMigration, Cluster, iSCSI) en ne sélectionnant pas This network adapter…

- …A la place, sélectionnez, en dessous de IP address configuration, Static, puis sélectionnez dans IPv4 pool le pool correspondant, par exemple IPP-Cluster.

- Enfin cliquez sur OK

Note au sujet de la QoS par défaut: Par défaut, la somme des poids attribués à « Host Management », « LiveMigration », « Cluster » et « iSCSI » font 100…sur 100. Si vous devez ajouter les machines virtuelles sur ce même logical switch, je vous conseille vivement de revoir les poids de ces workloads avant d’ajouter les VMs.

En PowerShell:

La même opération en Powershell…On retrousse ses manches, et on retient sa respiration, voici les commandes générées par SCVMM:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 |

$vmHost = Get-SCVMHost -ComputerName "hyperv1.vInfra.local" $networkAdapter = Get-SCVMHostNetworkAdapter -Name "Realtek PCIe GBE Family Controller" -VMHost $vmHost $uplinkPortProfileSet = Get-SCUplinkPortProfileSet -Name "UPP-Geneva-Network_5e1f8308-a5db-4cd6-93d4-8d1666601d05" -ID "5a0b5bfd-1028-4f9a-857d-8624f3b21de9" Set-SCVMHostNetworkAdapter -VMHostNetworkAdapter $networkAdapter -UplinkPortProfileSet $uplinkPortProfileSet -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" $networkAdapter = Get-SCVMHostNetworkAdapter -Name "ASIX AX88179 USB 3.0 to Gigabit Ethernet Adapter" -VMHost $vmHost $uplinkPortProfileSet = Get-SCUplinkPortProfileSet -Name "UPP-Geneva-Network_5e1f8308-a5db-4cd6-93d4-8d1666601d05" -ID "5a0b5bfd-1028-4f9a-857d-8624f3b21de9" Set-SCVMHostNetworkAdapter -VMHostNetworkAdapter $networkAdapter -UplinkPortProfileSet $uplinkPortProfileSet -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" $networkAdapter = @() $oneAdapter0 = Get-SCVMHostNetworkAdapter -Name "Realtek PCIe GBE Family Controller" -VMHost $vmHost $networkAdapter += $oneAdapter0 $oneAdapter1 = Get-SCVMHostNetworkAdapter -Name "ASIX AX88179 USB 3.0 to Gigabit Ethernet Adapter" -VMHost $vmHost $networkAdapter += $oneAdapter1 $logicalSwitch = Get-SCLogicalSwitch -Name "LS-Network" -ID "144d774d-5c1a-4d49-a7a4-3283d762d0e3" $vmNetwork = Get-SCVMNetwork -Name "VMN-Management" -ID "d8fbd78e-fa82-4205-9d70-c949dc5dd635" $portClassification = Get-SCPortClassification -Name "Host management" -ID "9510380e-6f97-4ee0-9be5-07cc25a2a1a9" New-SCVirtualNetwork -VMHost $vmHost -VMHostNetworkAdapters $networkAdapter -LogicalSwitch $logicalSwitch -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" -CreateManagementAdapter -ManagementAdapterName "Management" -ManagementAdapterVMNetwork $vmNetwork -ManagementAdapterPortClassification $portClassification $vNicLogicalSwitch = Get-SCLogicalSwitch -Name "LS-Network" -ID "144d774d-5c1a-4d49-a7a4-3283d762d0e3" $vmNetwork = Get-SCVMNetwork -Name "VMN-Cluster" -ID "33fc1614-e3e5-4917-9781-7cd7753a7f04" $vNICPortClassification = Get-SCPortClassification -Name "Host Cluster Workload" -ID "bdb5ca28-1f40-41e1-ab49-35e154e5962e" $ipV4Pool = Get-SCStaticIPAddressPool -Name "IPP-Cluster" -ID "be9120c4-9b64-4800-a2fe-1c6dfd36a31a" New-SCVirtualNetworkAdapter -VMHost $vmHost -Name "Cluster" -VMNetwork $vmNetwork -LogicalSwitch $vNicLogicalSwitch -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" -VLanEnabled $true -VLanID 302 -PortClassification $vNICPortClassification -IPv4AddressType "Static" -IPv4AddressPool $ipV4Pool -MACAddressType "Static" -MACAddress "00:00:00:00:00:00" $vNicLogicalSwitch = Get-SCLogicalSwitch -Name "LS-Network" -ID "144d774d-5c1a-4d49-a7a4-3283d762d0e3" $vmNetwork = Get-SCVMNetwork -Name "VMN-LiveMigration" -ID "80bb8eab-bfdb-4bbd-a25d-b970fa92dc34" $vNICPortClassification = Get-SCPortClassification -Name "Live migration workload" -ID "9d692f2c-8521-4ab5-81ac-17b38156d481" $ipV4Pool = Get-SCStaticIPAddressPool -Name "IPP-LiveMigration" -ID "c026e3a4-0ade-4356-a002-4a2cf33738af" New-SCVirtualNetworkAdapter -VMHost $vmHost -Name "LiveMigration" -VMNetwork $vmNetwork -LogicalSwitch $vNicLogicalSwitch -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" -VLanEnabled $true -VLanID 100 -PortClassification $vNICPortClassification -IPv4AddressType "Static" -IPv4AddressPool $ipV4Pool -MACAddressType "Static" -MACAddress "00:00:00:00:00:00" $vNicLogicalSwitch = Get-SCLogicalSwitch -Name "LS-Network" -ID "144d774d-5c1a-4d49-a7a4-3283d762d0e3" $vmNetwork = Get-SCVMNetwork -Name "VMN-iSCSI" -ID "543dbdd3-6a78-4f8b-8bb4-caae0a2caede" $vNICPortClassification = Get-SCPortClassification -Name "iSCSI workload" -ID "d18b6d1a-96fe-49d0-bc44-e889109e69c5" $ipV4Pool = Get-SCStaticIPAddressPool -Name "IPP-iSCSI" -ID "1451f3ef-2c02-4e9c-b5df-73be09ab3a6c" New-SCVirtualNetworkAdapter -VMHost $vmHost -Name "iSCSI" -VMNetwork $vmNetwork -LogicalSwitch $vNicLogicalSwitch -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" -VLanEnabled $true -VLanID 950 -PortClassification $vNICPortClassification -IPv4AddressType "Static" -IPv4AddressPool $ipV4Pool -MACAddressType "Static" -MACAddress "00:00:00:00:00:00" Set-SCVMHost -VMHost $vmHost -JobGroup "0aef59a3-1dc7-43e2-a9f9-1e088e12d34e" -RunAsynchronously |

Next step

Félicitation, vous avez configuré votre (premier) serveur Hyper-V pour utiliser un Logical Switch avec des cartes réseau en Teaming en utilisant SCVMM ! Mais aussi pour utiliser des Logical Networks, des Static Address IP Pools, des Uplink Port Profiles, des Network Classifications, et surtout, en ayant une configuration réutilisable à l’infini et au-delà sur tous les serveurs Hyper-V, notamment pour une utilisation en cluster.

Comme vous avez pu le constater, contrairement à une configuration sans SCVMM, les étapes 1 à 8 sont un peu plus fastidieuses, mais je vous recommande vivement de les réaliser pour vous simplifier la vie lors de l’ajout de nouveaux serveurs Hyper-V et éviter les problèmes de clustering et de configuration lors des migrations de machines virtuelles.

Dans le prochain article, nous verrons la configuration réseau de base de serveurs Hyper-V en cluster, les logical networks à bien ajouter, à quelles configurations il faut bien faire attention et pourquoi les ajouter pour avoir un cluster fiable et performant.

Partie 6: Configuration du teaming sous SCVMM 2012 SP1/R2 (6/7) Fin du support principal de SCVMM 2008 (R2)